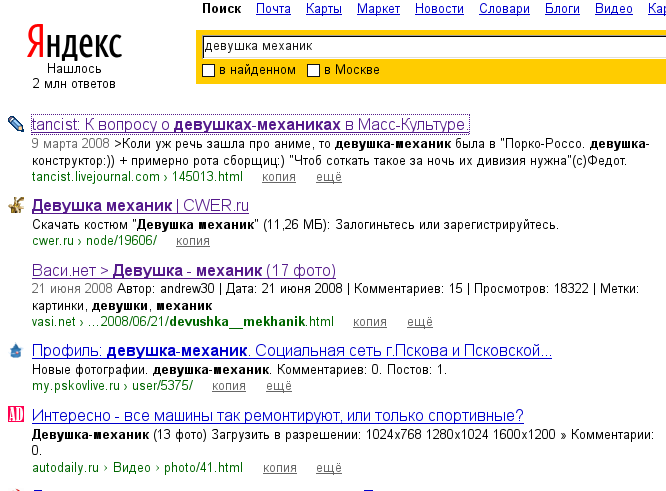

Что выдаёт поисковик при запросе “девушка механик”, особенно в картинках, думаю, писать не надо. Выглядит это примерно так:

Третья и пятая ссылки особо показательны. :) На всезнающем Гугле ситуация ни чуть не лучше.

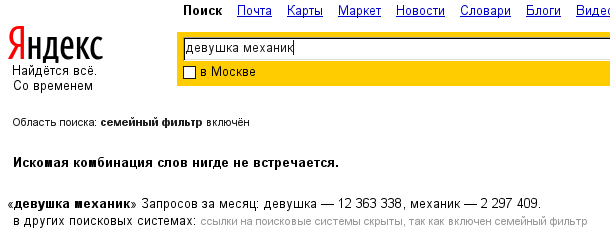

Однако, “Школьный Яндекс”, призванный защитить подрастающее поколение от тлетворного влияния запада нежелательного для детей контента успешно фильтрует нежелательные результаты поиска, в прочем, как и все остальные:

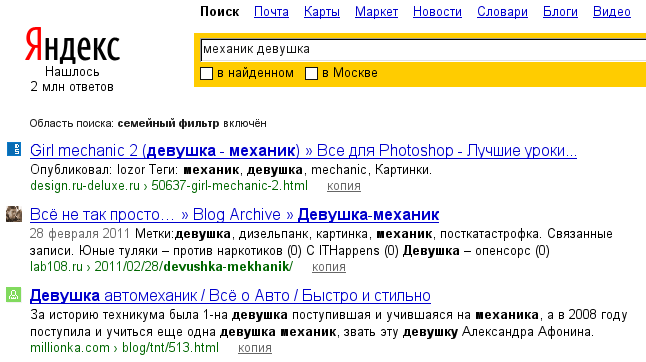

Однако, если переставить слова местами… и поискать “механика девушку”, то семейный фильтр считает, что всё в порядке и отлично выводит результаты. Ага. И картинки тоже.

Они бы настроили распознание фотографий с голозадыми девицами. Жизнь бы существенно облегчилась